美國法律對於 AI 招募偏見 的觀點

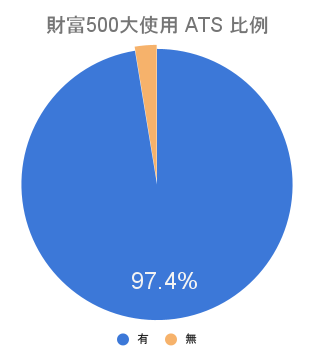

人工智慧(AI)在招募和人力資源管理領域中扮演著越來越重要的角色。然而,AI招募偏見是過程中很容易產生的問題,這對公平和多元化構成了挑戰。

2018年路透社的報導中,直接就點出了 Amazon的招募AI不喜歡女性,而原因來自於原先科技行業中本來男性就佔有主導地位導致的偏見。

沒人希望看到這種情況發生,但因為AI招募的成長勢不可擋,所以相關法規也開始探討 AI招募偏見。

美國平等就業機會委員會(EEOC) 怎麼看待 AI招募偏見

從2021年以來,美國平等就業機會委員會(EEOC)就持續關注在工作場所使用人工智慧技術(AI)可能造成的潛在危害。在2023年5月18日,EEOC針對先前 AI 不公平影響指導原則(AI Disparate Impact Guidance )文件,增補了一份名為《遴選問題:評估在1964年民權法案第七章下使用的軟體、演算法和人工智慧在雇用遴選流程中可能產生的不良影響》的技術協助文件。

增補文件主要關注人工智慧的使用可能涉及到1964年民權法案第七章,該法案禁止根據種族、膚色、宗教、性別和國籍而有就業歧視。EEOC關注AI對於招聘、解雇和晉升等「遴選流程」可能產生的不平等影響。(這不是一個全新政策;而是針對民權法案第七章法定條款中已經確立的原則做AI解釋上的補強)

《民權法案第七章》的背景

美國《民權法案第七章》的制定旨在保護求職者和雇員免受基於種族、膚色、宗教、性別和國籍的歧視。《民權法案第七章》也是平等就業機會委員會(EEOC)的法案。在將近60年的歷史中,《民權法案第七章》的解釋已擴大,包括保護免受性騷擾和基於懷孕、性取向、性別認同、殘疾、年齡和基因信息的歧視。該法案禁止雇主在招聘、錄用、監控、晉升、調動和解雇員工等與就業相關的決策中進行歧視行為。

《民權法案第七章》中歧視可以分為兩個主要類別:(1)不公平對待,指雇主故意進行的歧視性決策;(2)不公平影響,指作為雇主的模式和慣例所導致的非故意歧視。如上所述,平等就業機會委員會(EEOC)的 AI 不公平影響指導原則(AI Disparate Impact Guidance ) 主要關注人工智慧(AI)對後者的影響。

定義在遴選流程中使用AI的範圍

一開始最重要的是,雇主要了解,怎樣就算是有在決策遴選過程中使用AI。

任何評估、組合的評估與流程都算是遴選流程。所以它涵蓋了從求職者面試一直到員工離職的所有範圍。以下是幾個雇主在遴選過程中使用AI的例子:

-

- 掃描履歷的工具,根據特定關鍵詞對求職者進行優先排序;

-

- 監控軟體,根據按鍵敲擊或其他因素對員工進行評分;

-

- 「虛擬助手」或「聊天機器人」,向求職者詢問他們的資格,並拒絕那些不符合預先設定要求的人;

-

- 視訊面試軟體,根據求職者的面部表情和語音模式對其進行評估;

-

- 測試軟體,根據求職者或員工在遊戲或更傳統的測試中的表現,提供與其個性、能力、認知技能的各種分數。

怎樣算是AI導致了不公平影響(偏見)?

首先先定義一些會用到的名詞:

遴選率:指實際獲得錄用、晉升、解雇或其他選擇的申請人或候選人的比例。計算方法是將被選擇的特定群體的申請人或候選人總數除以該群體總數。舉例來說20個人中如果有6個人獲得升遷,那遴選率就是 6/20 = 30%。

特定族群遴選率:將該群體中被聘用、晉升或其他方式選擇的人數除以該群體的總人數來計算的。

舉例來說公司中有10個男性,10個女性。這次升遷中男性有2人升遷,女性有4人升遷。那:

女性群體遴選率:2/10 = 20%

男性群體遴選率:4/10 = 40%

回到如何定義AI導致不公平影響,指導原則中說到,如果某個特定群體的選擇率低於最受青睞群體選擇率的80%或五分之四,則其遴選率被認為「顯著地」較低。

平等就業機會委員會(EEOC)稱之為「五分之四法則」。然而,EEOC警告,遵守「五分之四法則」並不能保證遴選方法 100% 合規。五分之四法則並不適用於所有情形,特別在它無法合理代表統計顯著性測試的情況下。」但這可以當作一個經驗法則作為參考。

我們以下方資料為例:

| 總群體人數 | 遴選人數 | 遴選率 | 遴選率/ 最高遴選率 |

是否違反 五分之四法則 |

|

| A群體 | 100 | 15 | 15% | 100% | |

| B群體 | 100 | 14 | 14% | 93% | X |

| C群體 | 100 | 8 | 8% | 53% | O |

| D群體 | 100 | 13 | 13% | 87% | X |

C群體就是遴選率顯著地較低,如果這樣的遴選結果是AI導致的,那這就是AI導致了不公平的影響。

如何面對AI 可能導致的招募偏見

即使AI工具是由第三方廠商設計開發,雇主還是要對這個決策工具負責,可以透過以下方式降低AI導致招募偏見:

-

- 要求員工在使用AI工具之前獲得公司核准,以便公司對該工具進行審查。

-

- 要求軟體供應商揭露他們如何評估AI工具是否可能導致不公平影響所採取的步驟。如果AI工具會導致特定種族、膚色、宗教、性別或國籍群體的遴選率大大降低,那雇主必須確認這是否跟工作需求有特殊原因導致,不然就應該考慮替換別的工具。

-

- 確保您的軟體供應商協議中有適當的賠償和合作條款。

-

- 確保員工有受到足夠的AI工具培訓,不會無意識的導致了招募偏見。

-

- 如果你的外包廠商也會幫公司作出就業相關的決策,那要要求他們揭露所使用的AI決策工具,以便可以正確評估風險。

結論

AI在招募中的偏見問題是一個需要嚴肅對待並持續努力解決的問題,先前的新聞中提到,台灣也正在研擬人工智慧基本法,我們不應該忽略這個潛在的風險。

除了使用AI,更要確認我們使用的是否是可信任的AI,以招募AI來說,從訓練數據的多樣性、AI演算法的公平性、AI模型的透明與可解釋性、如何持續監測AI是否沒有產生偏見,一直到如何結合人力去平衡AI偏見,這都是我們新面臨到的問題。

雖然提到了以上這些AI遴選的偏見問題,但不可否認AI絕對可以加強招募的效率,只是我們需要意識到,AI技術本身並非完美無缺,也存在偏見和資訊不完全性的問題。以目前來說,我們應該把AI當作招募的輔助工具,而不能取代人類的判斷和道德責任。

想多了解如何兼顧可信任的AI與透過 AI招募效率,歡迎在下方留言告訴我們,Spotone團隊很高興跟您分享更多實際的作法。

相關連結:

Amazon AI 招募偏見:https://www.reuters.com/article/us-amazon-com-jobs-automation-insight-idUSKCN1MK08G

The Use Of Artificial Intelligence In Employee Selection Procedures: Updated Guidance From The EEOC:https://www.mondaq.com/unitedstates/employee-rights-labour-relations/1327672/the-use-of-artificial-intelligence-in-employee-selection-procedures-updated-guidance-from-the-eeoc

EEOC Issues Nonbinding Guidance on Permissible Employer Use of Artificial Intelligence to Avoid Adverse Impact Liability Under Title VII:https://www.klgates.com/EEOC-Issues-Nonbinding-Guidance-on-Permissible-Employer-Use-of-Artificial-Intelligence-to-Avoid-Adverse-Impact-Liability-Under-Title-VII-5-31-2023